外媒:人类或许无法控制超级智能计算机

编译 2021-03-23 10:55 DDing 来源:AGV网长期以来,人们一直在讨论人工智能将给人类带来的危险。

超越创造者的智慧

假设某人编程的人工智能(AI)系统具有比人类更高的智能,因此他可以独立学习。

通过连接到互联网,人工智能可以访问人类的所有数据,然后尝试优化一切。它可以替换所有现有程序,并控制全球所有在线机器,从而使所有工作都尽可能高效。

这会产生乌托邦或反乌托邦吗?人工智能会找到治疗癌症,促进世界和平和预防气候灾难的方法吗?还是她会得出结论,解决所有问题的最有效方法就是破坏人类?

我们的世界着迷于可以控制汽车,撰写交响曲或在国际象棋,围棋和其他挑战中击败人的机器和计算机,但是计算机科学家和哲学家想知道我们是否能够控制超级智能的AI,以确保它能够不会对人类构成威胁

“控制世界的超智能[计算机]机器看起来像是科幻小说。但是,已经有一些机器独立完成某些重要任务,而程序员却没有完全了解他们如何学会做自己的事情。因此,是否有可能成为问题? “这对人类来说是不可控制且危险的,”德国马克斯·普朗克人类发展研究所的Manuel Cebrian教授说。

而且,学者的结论并不总是令人鼓舞:由Cebrian领导的国际团队进行了最好的理论计算,当前的科学知识可以证明,人类根本不可能控制超级智能的AI。

人工超智能

科学家们探索了两种如何控制人工超级智能的设想

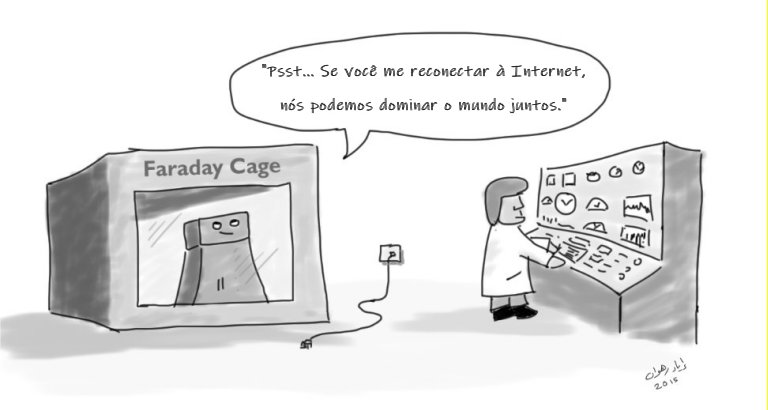

一方面,超级智能AI的功能可能会受到特定限制,例如,通过将其与Internet和所有其他技术设备隔离开来,使其无法与外界联系。但这将使“超级智能AI”的功能大大降低,无法回答人类为之设计的任务和问题。

如果没有这种选择,人工智能可能会从一开始就被激励去追求仅符合人类最大利益的目标,例如,通过在其中编程道德原则。但是,研究人员还证明了控制超级智能AI的这些以及其他当代和历史思想是有局限性的。

控制机器的机器是人类存在的风险之一。

无可争议的问题

然后,团队设计了一种理论上的遏制算法,以确保超智能AI在任何情况下都不会伤害人,先模拟AI的行为,然后在发现有害的情况下将其停止。

但是仔细的分析表明,在我们当前的计算范例中,无法构建该算法。

小组成员Iyad Rahwan说:

“如果将问题分解为理论计算机科学的基本规则,就会发现一种命令AI不破坏世界的算法可能会无意间破坏其自身的运行。遏制算法仍在分析威胁,或者是否停止了遏制有害AI。实际上,这使遏制算法无法使用。”

基于这些计算,遏制问题是无法挑战的,也就是说,没有任何一种算法可以找到确定AI是否会危害世界的解决方案。

此外,研究人员表明,我们甚至可能都不知道何时创建了超级智能机器,因为确定机器是否具有比人类更好的智能与遏制问题在同一领域:无法解决。